Step 2 of 6

Gestion des incidents critiques

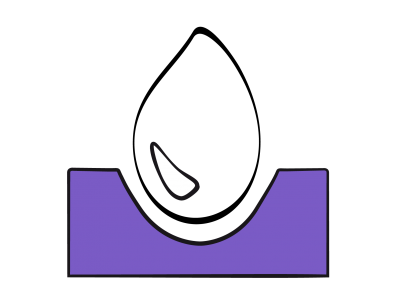

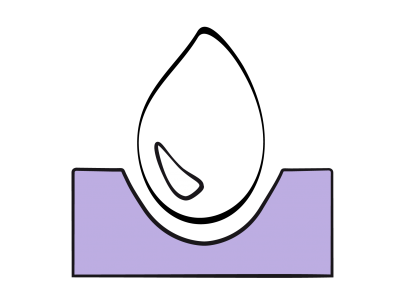

L’incident critique est une situation qui, si elle n’est pas corrigée à temps, conduit à l’accident. Ce dernier est défini comme un dommage irréversible. Lorsque survient un événement inattendu lié à un défaut d’organisation ou de matériel, à une pathologie intercurrente du patient, à une erreur humaine ou à une négligence, les marges de sécurité et les protocoles de l’institution fonctionnent comme des défenses (Figure 2.1).

Figure 2.1 : Modèle schématique de l’articulation entre anomalie, incident critique et accident. Si les défenses fonctionnent normalement, l’anomalie ou l’erreur est corrigée par la présence de marges de sécurité et d’algorithmes de panne ; elle n’entraîne pas de conséquences. Si les défenses sont insuffisantes ou lacunaires, l’anomalie progresse vers l’incident critique ; si celui-ci n’est pas corrigé à temps, il occasionne un accident. La récupération d’un incident critique que les défenses n’ont pas prévenu demande en général d’inventer une réponse à une situation inattendue et le plus souvent inconnue [5,7].

L’anomalie ou l’erreur est corrigée et n’entraîne pas de conséquences ; ceci relève des routines du service et des connaissances de l’anesthésiste. Si les défenses sont insuffisantes ou lacunaires, l’anomalie progresse vers l’incident critique ; si celui-ci n’est pas corrigé à temps, il occasionne un accident. La récupération d’un incident critique que les défenses n’ont pas prévenu demande en général d’inventer une réponse à une situation inattendue et le plus souvent inconnue [7]. Comme les incidents ont les mêmes précurseurs que les accidents, leur analyse permet d’accroître les connaissances et de les résoudre plus aisément lorsqu’ils se répéteront (voir Améliorations possibles, rapport des incidents critiques).

L’anomalie ou l’erreur est corrigée et n’entraîne pas de conséquences ; ceci relève des routines du service et des connaissances de l’anesthésiste. Si les défenses sont insuffisantes ou lacunaires, l’anomalie progresse vers l’incident critique ; si celui-ci n’est pas corrigé à temps, il occasionne un accident. La récupération d’un incident critique que les défenses n’ont pas prévenu demande en général d’inventer une réponse à une situation inattendue et le plus souvent inconnue [7]. Comme les incidents ont les mêmes précurseurs que les accidents, leur analyse permet d’accroître les connaissances et de les résoudre plus aisément lorsqu’ils se répéteront (voir Améliorations possibles, rapport des incidents critiques).

La surveillance continue de la SpO2 et de la PetCO2 a considérablement amélioré la sécurité en anesthésie parce que la modification de ces valeurs est une alarme très précoce d’un problème hémodynamique et/ou ventilatoire ; elle permet précisément de réagir avant l’incident. Bien que la sophistication constante du monitoring aille dans le même sens, l’intégration des données reste souvent déficiente : accumulation de chiffres, ergonomie misérable de l’affichage, complexité des données, alarmes nombreuses et mal hiérarchisées dont on élargit les seuils pour éviter la saturation [11]. Un maximum de moniteurs n’est pas synonyme d’un optimum de surveillance. On est encore loin de la clarté et de la précision des nouveaux cockpits de l’aviation civile.

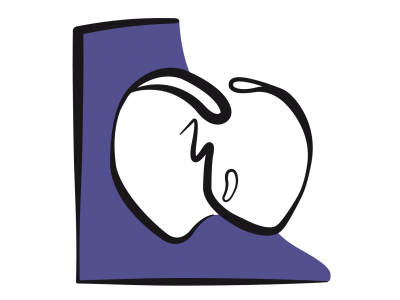

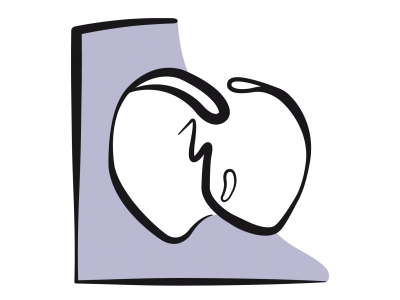

Les évènements aigus sont fréquents en salle d’opération : dans 18% des cas, l’anesthésiste doit résoudre une déviation inattendue, et dans 3-5% des cas, il survient un problème majeur nécessitant une intervention immédiate [6]. Or la moitié de ces incidents arrive pendant le maintien de l’anesthésie, c’est-à-dire pendant une période où l’attention tend à se relâcher. En effet, les performances d’un individu sont optimales à un certain niveau de stress, car celui-ci maintient un certain degré d’anxiété, donc de vigilance et de sécurité. Si le stress augmente, les performances ont tendance à baisser par perte des moyens sous l’effet de la panique, mais s’il baisse trop, l’ennui s’installe et la vigilance devient défaillante (Figure 2.2).

Figure 2.2 : Courbe schématique de l’évolution des performances humaines en fonction du niveau de stress. Le niveau optimal est la zone (1), situation d'équilibre entre l'ennui lorsqu'il ne se passe rien (2), d'une part, et la panique lorsque la catastrophe menace et que l'agitation mentale fait perdre les moyens, d'autre part (3).

Figure 2.2 : Courbe schématique de l’évolution des performances humaines en fonction du niveau de stress. Le niveau optimal est la zone (1), situation d'équilibre entre l'ennui lorsqu'il ne se passe rien (2), d'une part, et la panique lorsque la catastrophe menace et que l'agitation mentale fait perdre les moyens, d'autre part (3).

Erreurs cognitives

Pour comprendre le fonctionnement psychique dans les situations aiguës, il est nécessaire de rappeler que nous disposons schématiquement de deux manières de gérer notre action en fonction des circonstances [1,9].

- Niveau d’intégration faible (Type I) : automatismes, schémas mentaux, intuitions. Les routines permettent un débit élevé d’actions simultanées (on peut tenir une conversation tout en conduisant correctement sa voiture), les réflexes assurent une parade rapide en cas de danger (on freine spontanément devant l’obstacle) et l’intuition se base sur les expériences mémorisées. Chacun possède en tête un certain nombre de protocoles automatiques en cas de problème : l’apparition d’une cyanose chez le patient déclenche une hyperventilation à 100% d’O2 chez l’anesthésiste. Ce mode de fonctionnement est cependant condamné à répéter des gestes appris et à rechercher l’analogie avec des situations déjà vécues ; il ne permet pas de trouver une solution nouvelle à un problème inconnu. Ainsi, lorsqu’on a perdu la maîtrise d’une situation, on se raccroche à ce qu’on a l’habitude de suivre, comme le démontre l’accident du vol Rio-Paris (1er juin 2009), où les pilotes se sont fixés sur les données des instruments directeurs de vol habituels sans réaliser que l’appareil était en décrochage.

- Niveau d’intégration élevé (Type II) : réflexion analytique consciente. Cette recherche d’une solution en fonction des multiples données de la situation impose un débit lent et séquentiel (on ne réfléchit qu’à une seule chose à la fois), mais elle permet d’inventer une solution adaptée à une situation nouvelle. En cas d’échec, c’est une erreur de jugement.

Les erreurs cognitives sont des défauts de fonctionnement de ces systèmes. Elles sont souvent inconscientes, et ne sont pas limitées à des manques de connaissance théorique ou pratique. Elles sont plus difficiles à codifier et à repérer que les erreurs intellectuelles ou les défauts dans une technique, car elles ont trait à l‘heuristique, qui est la manière dont nous recherchons une solution simple à un problème complexe lorsque nous ne disposons pas de toutes les informations nécessaires pour prendre une décision rationnelle [4]. Il existe toute une série d’erreurs cognitives : effet tunnel, confirmation, minimalisation, précipitation, omission, raccourcis mentaux, distorsion de mémoire, biais induits par les émotions ou les contraintes sociales (voir ci-après) [8,10].

Dans les situations de crise où il faut réagir très rapidement, le psychisme humain retourne à des comportements réflexes et perd momentanément sa capacité d’analyse critique. Il compare la situation à des expériences semblables enregistrées dans sa mémoire à long terme. Un expert dispose ainsi d’un vaste répertoire de routines dans un domaine particulier. Ce sont des comportements réflexes qui sont efficaces pour la survie mais qui présentent des défauts potentiellement dangereux. En dépit de leur rapidité, ils ne sont efficaces que dans les situations correspondant à celles déjà vécues. Ils sont dénués d’esprit analytique et ne peuvent ni inventer une solution originale à une situation inconnue, ni avoir une position de recul vis-à-vis de l’action en cours. Ils sont aveugles à la complexité de la situation, et partent du principe que la solution la plus simple est souvent la meilleure, ce qui a l’avantage de la célérité lorsque certaines informations-clés ne sont pas disponibles [9].

Dans les situations de crise où il faut réagir très rapidement, le psychisme humain retourne à des comportements réflexes et perd momentanément sa capacité d’analyse critique. Il compare la situation à des expériences semblables enregistrées dans sa mémoire à long terme. Un expert dispose ainsi d’un vaste répertoire de routines dans un domaine particulier. Ce sont des comportements réflexes qui sont efficaces pour la survie mais qui présentent des défauts potentiellement dangereux. En dépit de leur rapidité, ils ne sont efficaces que dans les situations correspondant à celles déjà vécues. Ils sont dénués d’esprit analytique et ne peuvent ni inventer une solution originale à une situation inconnue, ni avoir une position de recul vis-à-vis de l’action en cours. Ils sont aveugles à la complexité de la situation, et partent du principe que la solution la plus simple est souvent la meilleure, ce qui a l’avantage de la célérité lorsque certaines informations-clés ne sont pas disponibles [9].

Effet tunnel

L’effet tunnel (ou fixation, ou ancrage) est un blocage cognitif qui enferme l’individu dans un seul diagnostic ou une seule activité. Obnubilé par l’option choisie pour résoudre rapidement le problème survenu, l’acteur est dans l’impossibilité de la remettre en question en fonction de données discordantes. Concentré sur un seul facteur, il ne peut plus avoir de vision d’ensemble de la situation. Au contraire, il interprète toutes les informations en fonction d’une confirmation du schéma qu’il a sélectionné et de l’action pour laquelle il a opté [3]. Ainsi, on persiste à vouloir intuber un patient malgré les échecs répétés d’essais itératifs alors qu’il désature et devient bradycarde. La pression de l’urgence, les alarmes, les conversations et le bruit ne font que renforcer cette fixation. "La bêtise, disait Einstein, consiste à répéter encore et encore la même action en espérant obtenir un résultat différent"!

D’autres processus bloquent le mental dans la recherche de solutions à un problème aigu et contribuent à la fixation sur un seul élément.

D’autres processus bloquent le mental dans la recherche de solutions à un problème aigu et contribuent à la fixation sur un seul élément.

- Précipitation sur le premier diagnostic venu à l’esprit et fermeture mentale aux autres possibilités ; le problème n’est pas la justesse ou la fausseté du diagnostic, mais la disparition de tout esprit critique.

- Scotomisation des données qui contredisent l’option choisie en premier lieu.

- Incapacité à ajuster un diagnostic avec de nouveaux éléments ou à corriger l'idée initiale par le feed-back du cours des évènements.

- Biais d’interprétation ; quels qu’ils soient, les résultats de l’action entreprise sont interprétés dans le sens d’une confirmation de l’option choisie ; l’absence de réponse à une manœuvre est ressentie comme un feed-back positif.

Ayant forcément une vision un peu différente de la situation, un collègue est susceptible de découvrir un élément-clef qui avait échappé à l’observation à cause de l’effet tunnel. Une équipe est donc beaucoup plus performante qu’un individu isolé dans les moments de stress, car sa nature composite fait qu’elle dispose de plusieurs angles de vue et qu’elle procède à une ré-évaluation fréquente de la situation à cause des idées différentes émises par chacun de ses membres.

Tendance à la minimalisation, à la certitude et à l'agitation

Un trait caractéristique des situations de crise est d’engendrer une tendance à la minimalisation, manière inconsciente de conserver l’espoir que tout va s’arranger. C’est une attitude dangereuse à cause de la sous-estimation constante des risques encourus. Si l’on ne garde pas à l’esprit les complications potentielles, on est toujours démuni lorsqu’elles se présentent [1].

Lorsqu'une décision devient impérative, l'esprit humain tend à choisir l'option qui paraît contenir le plus de certitude et le moins de risque, même si elle reconnue pour ne pas être la plus probable ni la plus adaptée à la situation. Il tend de même à faire quelque chose plutôt que de rester passif, même si cette activité n'a aucune espèce d'impact sur la situation; cette suractivité sans efficacité sur la situation présente n'est que de l'agitation anxiolytique [10].

Lorsqu'une décision devient impérative, l'esprit humain tend à choisir l'option qui paraît contenir le plus de certitude et le moins de risque, même si elle reconnue pour ne pas être la plus probable ni la plus adaptée à la situation. Il tend de même à faire quelque chose plutôt que de rester passif, même si cette activité n'a aucune espèce d'impact sur la situation; cette suractivité sans efficacité sur la situation présente n'est que de l'agitation anxiolytique [10].

Facteurs psychologiques

De nombreux comportements psychiques interfèrent avec une démarche adéquate dans les situations de stress [10].

- Sélection d’un diagnostic sur la base des mauvaises expériences du passé ou des craintes du moment, non sur la probabilité réelle de son existence dans la situation donnée.

- Agitation.

- Omission : tendance inverse à hésiter devant une manœuvre vitale de peur qu’elle soit discutable ou de peur de ne pas la réussir.

- Ancrage sur un diagnostic parce que de le remettre en question est une blessure narcissique.

- Présomption ; tendance à se croire infaillible, à être invulnérable vis-à-vis des biais dans les raisonnements, refus d’appel à l’aide, négligence à suivre les recommandations officielles.

- Distorsion de mémoire liée à l'impact émotionnel d'un fait ancien ou à l'imprécision des souvenirs de détails.

- Affects vis-à-vis du patients : un sentiment positif ou négatif pour le malade modifie la tendance à persévérer ou à abandonner lors d’une réanimation.

- Contraintes sociales: peur du qu'en-dira-t-on, paralysie par la présence d'une autorité hiérarchique, désir de paraître adéquat.

- Regrets anticipés: la décision est dictée par le regret que l'individu pourrait développer ultérieurement s'il n'avait pas fait le maximum en son pouvoir, quand bien même il sait que les mesures prises sont inutiles.

Procédures de récupération

Analyser une situation et imaginer différentes solutions sont des opérations lentes qui demandent de pouvoir se concentrer. Cela n’est pas réalisable en situation de crise. Il existe plusieurs parades à cet état de fait.

- Les algorithmes de panne permettent de mettre en mémoire des schémas simples destinés à devenir des réflexes, parce que l’on serait bien en mal de les inventer sous l’effet du stress. C’est le but, par exemple, d’un algorithme d’intubation difficile (Figure 2.3). Cette suite finie de règles opératoires (algorithme vient de Al-Khawarizmi, mathématicien arabe du IXème siècle) est de plus connue de tous, ce qui crée une homogénéité dans l’action.

- Les check-lists sont plus fiables que la mémoire et empêchent d’oublier un diagnostic différentiel ou une manœuvre importante. Elles sont une excellente défense contre les diverses erreurs cognitives (voir Gestion globale de l'équipe, checklists) [2].

- Les recommandations (Guidelines) des sociétés médicales de spécialités offrent un éventail des meilleures stratégies dans de nombreuses situations, et sont basées sur le meilleur degré d'évidence. Les suivre est plus efficace qu'improviser.

- Lorsqu’une situation périlleuse est prévisible, on établit une stratégie à l’avance et à froid ; cette stratégie comporte des procédures de récupération en cas d’échec (plans B) ; elle est mise au point par l’équipe en charge. Avant une sortie de pompe difficile, par exemple, on se met d’accord entre anesthésistes, chirurgiens et perfusionistes sur la manière dont on va procéder (tempo, catécholamines, anti-arythmiques, etc) et de ce que l’on fait en cas de problème (reprise chiurgicale, contre-pulsion, assistance ventriculaire, etc).

- A tout instant, il est bon d’avoir en tête un plan d’action en cas de problème soudain, comme un pilote connaît les aéroports de détournement en cas de panne tout au long de sa route.

- Il est judicieux de toujours considérer au moins trois alternatives possibles au diagnostic prioritaire, particulièrement en situation d'urgence [10].

- La connaissance des erreurs cognitives qui surviennent dans les situations aiguës permet d’en minimiser les effets et de s’efforcer de conserver un certain esprit critique vis-à-vis des diagnostics et des décisions thérapeutiques d’urgence.

Figure 2.3 : Exemple de procédure de récupération : algorithme d’intubation difficile en usage au CHUV (Lausanne, 2008). Les étapes sont codifiées et connues de tous les membres du service d’Anesthésiologie ; le matériel nécessaire est contenu dans un chariot d’intubation difficile dont la localisation dans le bloc opératoire est bien précise.

La performance dans les situations de crise est fonction de l’expérience qu’on en a. De ce fait, le simulateur est un moyen extrêmement efficace de s’entraîner et d’acquérir les réflexes qui permettront de suivre les procédures adéquates dans les situations stressantes. Mais la limitation des horaires des assistants/internes/résidents (50 heures par semaine en Suisse, par exemple) diminue considérablement leur exposition aux cas cliniques complexes et freine leur acquisition d’une expérience des situations à risque.

| Evènement critique |

Un incident critique aigu survient en moyenne dans 4% des cas, pour la moitié pendant le maintien de l’anesthésie Dans ces situations de stress, on revient à un fonctionnement basé sur les automatismes et les réflexes appris des expériences passées. Ce comportement permet des actions rapides, mais empêche une analyse critique de la situation. Il enferme le psychisme dans un effet tunnel qui est un blocage cognitif sur une seule option dans la gestion d’un évènement critique |

| Procédures de récupération |

Les algorithmes et les règles de bonne pratique permettent de créer le réflexe adéquat en situation de crise (exemple : algorithme d’intubation difficile) La stratégie pour une situation à risque est établie à l’avance et connue de toute l’équipe A tout instant, il est judicieux d’avoir un plan d’action en cas de problème soudain |

© CHASSOT PG CLAVADETSCHER F Mars 2010, mise à jour Janvier 2012, Juillet 2017, Décembre 2019

Références

- COOPER JB, NEWBOWER RS, LANG CD, et al. Preventable anesthesia mishaps: a study of human factors. Anesthesiology 1978; 49:399-406

- ELY JW, GRABER ML, CROSKERRY P. Chcklists to reduce diagnostic errors. Acad Med 2011; 86:307-13

- FIORATOU E FLIN R, GLAVIN R. No simple fox for fixation errors: cognitive processes and their clinical applications. Anaesthesia 2010; 65:61-9

- GIGERENZER G, GAISSMAIER W. Heuristic decision making. Annu Rev Psychol 2011; 62:431-82

- NOLAN TW. System changes to improve patient safety. BMJ 2000; 320:771-3

- REASON J. Safety in the operating theatre : Part 2. Human error and organisational failure. Qual Saf Health Care 2005 ; 14 :56-60

- STAENDER SEA. Incident reporting in anaesthesiology. Best Pract Clin Res Anaesthesiol 2011; 25:207-14

- STIEGLER MP, NEELANKAVIL JP, CANALES C, et al. Cognitive errors detected in anaesthesiology: a literature review and pilot study. Br J Anaesth 2012; 108:229-35

- STIEGLER MP, RUSKIN KJ. Decision-making and safety in anesthesiology. Curr Opin Anaesthesiol 2012; 25:724-9

- STIEGLER MP, TUNG A. Cognitive processes in anesthesiology décision making. Anesthesiology 2014; 120:204-17

- TREMPER KK. Anesthesiology: from patient safety to population outcomes. The 49th Annual Rovenstine Lecture. Anesthesiology 2011; 114:755-70